|

ГЛАВНАЯ СТАТЬИ ПРОГРАММЫ ЛИТЕРАТУРА МЕРОПРИЯТИЯ |

Применение ячеистых нейронных сетей для определения формы по затенениюили "Применение ячеистых нейронных сетей для задачи определения формы по отражательной способности" Applications of Cellular Neural Networks for Shape from Shading Problem [ссылка на оригинал статьи на английском языке] Авторы:

Mariofanna Milanova1, Paulo E. M. Almeida2,

Jun Okamoto Jr.1 и Marcelo Godoy Simões1 1 Department of Mechanical Engineering — Escola Politécnica — USP Av. Prof. Mello Moraes, 2231 — São Paulo 05508-900, SP – BRAZIL 2 Department of Research and Postgraduate / CEFET — MG Av. Amazonas, 7675 — Belo Horizonte 30510-000, MG — BRAZIL перевод Пасяды А.В. в 2005 г. КРАТКИЙ ОБЗОРМодель Ячеистых Нейроподобных Сетей (ЯНС) состоит из множества параллельных аналоговых процессоров, вычисляющих в реальном времени. ЯНС в настоящее время представляют парадигму ячеистых аналоговых программируемых многомерных процессорных массивов с распределённой локальной логикой и памятью. Их особенность заключается в том, что эти процессоры расположены в двумерной сетке и имеют только локальные соединения. Эта структура может быть легко преобразована в реализацию на СБИС, где соединения между процессорами определены через клонирующий шаблон. Этот шаблон описывает интенсивность связей между ближайшими соседями в сети. Ключевой аспект статьи состоит в представлении новой методологии для решения задачи Распознавания Формы по Затенению, используя ЯНС. Здесь представлены и кратко обсуждены некоторые практические результаты, демонстрирующие успешную работу предложенного алгоритма. 1. Введение 1. ВведениеРазличие между техническим и природным зрением заключается во врождённом параллелизме и непрерывности значений времени и сигнала в последнем. В частности, клетки сетчатки комбинируют фототрансдукции (переносы генетического материала) и коллективной параллельной обработки для реализации низкоуровневых операций над изображением (особенности выделения, анализ движения и т. д.), одновременно с получением изображения. При сборе пространственно-временной информации из ряда изображений существуют пространственные представления этой информации. Парадигма Ячеистых Нейроподобных Сетей (ЯНС) основана на универсальной модели для пространственно-временных свойств зрительной системы [1], [2]. Многие задачи зрения относятся к зрительной реконструкции и могут трактоваться как задача оптимизации. Примером является распознавание формы по отражательной способности (по затенению (РФЗ)), распознавание кромок и рёбер, анализ движения, структурирование из движения и поверхностная интерполяция. Эти «некорректно поставленные», инверсные задачи решаются с помощью техник минимизации. Согласно Т. Поджо [4] (см. Таблицу 1) практику решений в техническом зрении можно представить так, что различные задачи технического зрения раннего и среднего уровня решаются минимизацией энергии различных функционалов. Как показано Кохом в [5], квадратичные вариационные задачи могут быть решены линейными аналоговыми электрическими или химическими сетями, использующими техники регуляризации, аддитивные модели или подходы случайных полей Маркова. Тем не менее, у квадратичных вариационных принципов есть ограничения. Главная проблема — степень гладкости, требуемая для неизвестных функций, по которым проводится восстановление. Например, когда схема интерполяции поверхности построена вокруг гладкой области через излом, она даёт сбой при вычислении сосредоточенных неоднородностей.

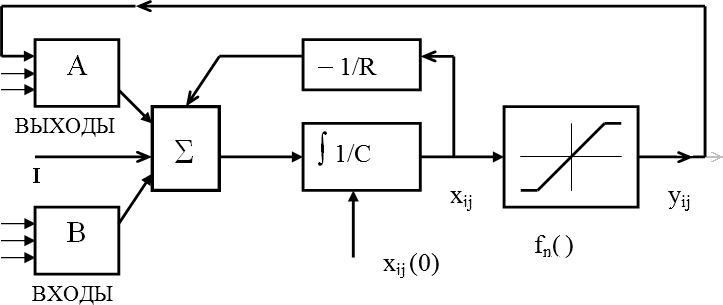

Хопфилд и Танк показали, что сети из нелинейных аналогов «нейронов» могут быть эффективнее при вычислении решения оптимизационной задачи (задача путешествующего коммивояжёра, задача стерео сравнения и т.д. [20]). Цель этой статьи — представить новую методологию для решения задачи распознавания формы по отражательной способности. Для этого используется приём на основе регуляризации, исходящий из моделирования случайных полей Маркова (СПМ) и минимизации энергии итерационным алгоритмом релаксации. Мы начали с математической точки зрения (т.е. статистической регуляризации, основанной на СПМ) и отобразили алгоритм на аналоговую сеть (ЯНС). Ясного восстановления формы мы достигли, используя пространственно-временное соседство для моделирования взаимодействий пикселов. Статья организована следующим образом: В разделе 2 кратко рассматривается архитектура ЯНС. В разделе 3 предлагается новый метод восстановления поверхности. В 4 разделе представлены результаты эксперимента, а 5 — обобщение статьи. 2 Архитектура Ячеистых Нейроподобных СетейЯчеистые нейронные сети (ЯНС) и универсальные машины ЯНС были представлены в 1988 и 1992 годах, соответственно в [1]-[3]. Наиболее общее определение таких сетей заключается в том, что ячеистые нейронные сети являются массивами идентичных динамических систем, ячеек, которые связаны только локально [2]. В исходной модели Чуа и Яна каждая ячейка — это одномерная динамическая система. Она является основным элементом ЯНС. Любая ячейка соединена только со своими соседними ячейками, т.е. смежная ячейка прямо взаимодействует с каждой. На несоседние ячейки оказывается косвенное взаимодействие из-за распространяющегося эффекта динамики в сети. Ячейка, находящаяся в положении (i, j) двумерного массива M × N, обозначена Cij, и её r-окрестность N rij определяется так Каждая ячейка имеет состояние x, постоянное внешнее значение на входе u, и значение на выходе y. Эквивалентная схема ячейки непрерывного действия по времени показана на рис.1.  Рис. 1 — Блок-схема одной ячейки Нелинейное дифференциальное уравнение первого порядка, определяющее динамику ячеистых нейронных сетей, может быть записано в виде: yij(t) = 0,5·(|xij(t) + 1| – |xij(t) – 1|) Матрицы A(.) и B(.) известны,

как клонирующие шаблоны. A(.) действует на выход соседних ячеек и

рассматривается как оператор обратной связи. B(.) в свою очередь

воздействует на входные значения и соответствует контролирующему

оператору. Конечно, A(.) и B(.) зависят от применения.

Постоянное смещение I и клонирующие шаблоны определяют временное

поведение ячеистой нелинейной сети. В общем, клонирующие шаблоны не

должны быть пространственно инвариантны. Они, конечно, могут быть таковыми,

но не обязательно. Существенной особенностью ЯНС

является то, что у неё две независимые способности: общий вход и

начальное состояние ячеек. Обычно они ограничиваются так: Так же, если |f(.)| ≤ 1 , то |yij(t)| ≤ 1 ЯНС выполняет отображение, когда используется как реализация вычислительного массива  :F

⇒ yij(t)

(4) :F

⇒ yij(t)

(4)

Функциональность матрицы ЯНС может контролироваться клонирующим шаблоном A, B, I, где A и B — это (2r + 1) × (2r + 1) действительные матрицы, а I — это скалярное число в двумерных ячеистых нейросетях. Во многих применениях A(i, j; k, l) и B(i, j; k, l) пространственно инвариантны. Если A(i, j; k, l) == A(k ,l ;i ,j), то ЯНС называется симметричной или обратной. Есть два главных случая: ЯНС непрерывного времени и ЯНС дискретного времени. Уравнения для каждой ячейки в ЯНС дискретного времени: xij(k) = Особый класс двумерной ячеистой нейронной сети описывается обыкновенными дифференциальными уравнениями такой формы (см. [2], [10]): где 1 ≤ i ≤ M, 1 ≤ j ≤ N, aij = 1/RC > 0, и xij являются состояниями сети, а yij — выходными значениями сети, а sat(.) представляет функцию активации. Мы задаём нулевые значения входных данных

(uij ≡ 0

для всех i и j) и постоянный вектор смещения С этими условиями мы сошлёмся на уравнения (6) как на несимметричную нейронную сеть с нулевыми входами, в которой n нейронов расположено в M×N массиве (с n = M×N), и структура связей ограничена местными соседями в радиусе r. Система (6) — это вариант рекуррентной модели Хопфилда с функцией активации sat(.). Есть также некоторые отличия от хопфилдовской модели:

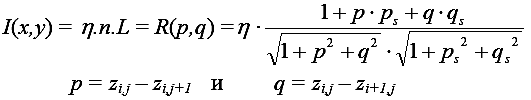

Наиболее популярное применение для ЯНС — это обработка изображений. Это естественно из-за их аналоговой особенности и редких (и/или распределённых) соединений, которые приводят к обработке информации в реальном времени [1], [8], [9]. Двумерная ЯНС может быть рассмотрена как параллельный нелинейный двумерный фильтр и уже применяется для устранения шума, распознавания формы, краёв (рёбер) и т.п. 3. Решение задачи распознавания формы по отражательной способности с помощью ячеистых нейронных сетей3.1 Задача распознавания формы по отражательной способности (по затенению)Распознавание формы по отражательной способности относится к процессам восстановления трёхмерной формы из монокулярного плоского изображения. Его успех зависит от: 1) подходящей модели представления, которая устанавливает связь между формой поверхности и яркостью изображения и 2) от хорошего численного алгоритма восстановления формы из данного изображения. В исследованиях РФЗ модель представления определяется через карту отражательной способности R(p, q), с p = dz/dx и q = dz/dy — это частные производные высоты z по отношению к координатам изображения и названы градиентами поверхности на (x, y). С определением карты отражательной способности задача РФЗ становится задачей нахождения наилучшего пути восстановления поверхности z(x, y), удовлетворяющего уравнению освещённости изображения  (7)

(7) (8)

(8) (9)

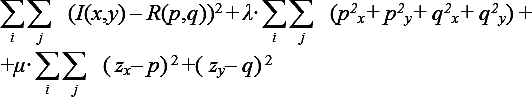

(9)Распознавание формы по затенению является полностью обратной задачей по отношению к задаче тонирования (визуализации): дано изображение I(x, y), найти поверхность S, альбедо η и свет L ,которые удовлетворяют равенству (7). Равенство (7) (равенство освещённости изображения) может быть рассмотрено как нелинейное уравнение в частных производных для функции поверхности z = z(p, q). К сожалению, этот подход не очень удобен для работы реальными объектами. Стандартные методы численного интегрирования дифференциальных уравнений (например, метод характеристической полосы) на практике дают отказ. Этим методам присуща высокая чувствительность к шуму и граничным условиям. Альтернативный подход заключается в решении оптимизационной задачи, в котором мы стремимся минимизировать среднюю ошибку между интенсивностью и освещённостью на функции энергии, как показано в уравнении (10). Оптимизационный подход в общем более гибок по отношению к дополнительным влияниям и более устойчив к шуму на изображении и ошибкам моделирования. Типичные функции энергии выводятся и обсуждаются в [11], [12], [13], [14], [15] и [16].  (10)

(10)Здесь первый член соответствует ошибке интенсивности, второй — член регуляризации (мера гладкости поверхности) и третий — член интегрируемости. Гримсон [17] предложил интерполяционную схему для получения значений высоты из изображения, которая соответствует подходящей тонкой гибкой пластине через рассматриваемые точки данных. Эту интерполяционную схему можно описать терминами стандартной теории регуляризации [5]. Функция энергии E(z) выводится из обратной задачи В приведённом уравнении первый член даёт меру расстояния решения к данным, а второй соответствует регуляризации, требуемой для корректной постановки задачи. S — это линейный оператор, связанный с оболочкой пластинки, зависящей от вида желательного сглаживания и α — параметр регуляризации. B — диагональная матрица с 1 в тех местах, где высота известна и 0 во всех остальных элементах. E(z) переформулировано так: В случае задачи квадратичной регуляризации E(V) является положительно определённым квадратным уравнением, следовательно, система будет всегда сходиться к уникальному минимуму энергии. Тем не менее, член квадратичной гладкости постоянно подавляет изменения формы поверхности, независимо от изменения интенсивностей. Насчёт использования нейронных сетей в распознавании формы по затенению можно вспомнить предыдущие работы [18], [19]. Согласно Ю и Цай [12], мы можем использовать нейросетевые техники для решения многих задач, которые уже решены релаксационным процессом. Некоторые исследователи используют оптимизационную способность модели Хопфилда для специфических задач оптимизации раннего зрения [6], [7]. Идея Хопфилда должна решать задачи комбинаторной оптимизации, если использовать вместо двоичных переменных переменные, способные меняться непрерывно между 0 и 1, а также представить члены в функции энергии, которая влияет на конечное решение, как один из углов гиперкуба [0;1]N. Короче говоря, пусть выходная переменная yi(t) для нейрона i лежит в диапазоне 0 < yi(t) < 1 и является непрерывной и монотонно возрастающей функцией внутреннего состояния переменной xi(t) нейрона i: yi = f(xi). Тогда на выходе (с сигмоидоподобной функцией): Хопфилд интерпретирует выражение (13) как функцию Ляпунова в сети. Как показал Бозе и Лян [21], ЯНС — это аналог сети Хопфилда, в которой связи ограничиваются локальными соседями отдельного элемента с двунаправленными путями сигнала. Динамика ЯНС описывается системой нелинейных обыкновенных дифференциальных уравнений типа (6) и функцией энергии ассоциативных вычислений (названной функцией Ляпунова), которая минимизируется в процессе вычислений. Полученное уравнение изменения, которое определяет степень изменения xij таково:  + I

(15)

+ I

(15)Нелинейность символьного типа, показанная в (6), заменяется сигмоидной нелинейной линейностью. В таком случае система становится динамической системой с непрерывным значением, в которой градиент хорошо определён, и можно применить классические оптимизационные алгоритмы. Функция Ляпунова E(t) для ЯНС дана такой: Используя подходяще определённую функцию энергии, устойчивость ЯНС может быть доказана так же как аналоговая или непрерывная сеть Хопфилда. Хопфилд и Танк [20] исследовали аналогию между нахождением решения для данной оптимизационной задачи и подбором подходящей функции Ляпунова, соответствующей аддитивной нейронной модели. Аналоговая сеть имеет два преимущества. Во-первых, в ней функция E — функция Ляпунова, а в цифровой сети нет. Во-вторых, более глубокие минимумы энергии обычно имеют более широкие бассейны притяжения. Случайно выбранное начальное состояние имеет бóльшую вероятность падения решения внутрь бассейнов притяжения более глубокого минимума. 3.2 Новый алгоритм для распознавания формы по отражательной способности (по затенению)Здесь мы предложили ещё один метод для распознавания поверхности, основанный на взаимодействиях между пикселями в случае парадигм ЯНС и СПМ. Т.к. ЯНС является процессом, управляемым интенсивностью, для случайного поля интенсивности в малой области допускается иметь свойства СПМ, т.е. распределение Гиббса и соседствующую структуру. Пространственно-временное соседство пикселей (или просто точек) дано как структура ЯНС. Возьмём ряд наблюдений на пиксельном уровне, где s=(i, j) дано посредством замены в функции интенсивности (уравнения освещённости изображения) функцией Согласно Герману [22], Коху [5] и Лютону [9], единственный путь вычислить Z является минимизация функции стоимости или энергии E, состоящей из двух членов Энергия модели Ea(z), вставленная априорно в моделирование пространственно-временных взаимодействий между точками, является членом регуляризации, похожим на ограничение гладкости, классически используемое для решения «некорректно поставленных задач». Добавочная энергия Eb(z) — это энергия ошибки интенсивности. Функция энергии может быть переписана как Минимум энергии может быть вычислен, используя или алгоритмы стохастической релаксации типа «имитации отжига» [22], или детерминистическими алгоритмами наподобие итеративных условных моделей (ИУМ) [23]. Здесь используется метод ИУМ. Минимум E, который касается всех zij, соответствует нулевым частным производным Итоговое дифференциальное уравнение, которое определяет степень изменения zij Релаксация ИУМ обегает вокруг поля z, которое сканируется пиксель за пикселем. В каждом узле принимается локальное решение Эта релаксация проводит итерации до тех пор, пока не достигнется схождение в

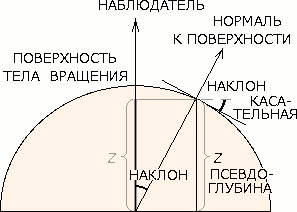

каждой из соседних систем, определённых в поле z. Для определения состояния сходимости используется

критерий уменьшения относительной энергии ΔE / E < ε. [Примечание переводчика: получаемые значения z — не

относительная высота или глубина в диапазоне, заданном функцией активации

нейроподобных элементов, когда, зная хотя бы одну точку с

известной глубиной, можно построить всю остальную глубину объекта

относительно той точки. В действительности z —

псевдоглубина, которая является простой функцией от наклона (!) поверхности.

Значения z будут верно отображать глубину на телах вращения,

но на участке вдоль наклонной плоскости вычисляемое предложенной

нейросетью значение z постоянно, при том, что нормальная

относительная глубина должна была бы меняться. На иллюстрации

результатов в следующем параграфе это неочевидно, так как там

восстанавливается форма криволинейных

поверхностей, не имеющих значительных участков с наклонными плоскостями.

Также вместо псевдоглубины можно было бы ЯНС обучить прямо вычислять

наклон, но в поле решений при нулевом наклоне появится скачок, который

усложнит задачу регуляризации (и я не изучал, но

не будет ли потеряна марковость данных при этих значениях? — стоит проверить).

Подробнее см. про z в разделе Переменные и

обозначения в статье.]

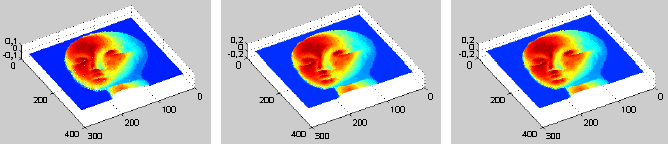

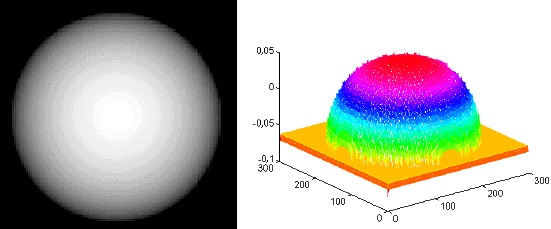

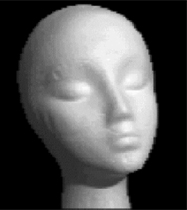

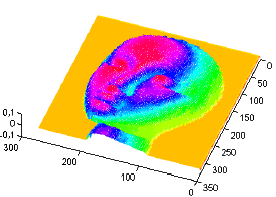

4. Результаты экспериментаНа описанном алгоритме релаксации ИУМ была сымитирована архитектура ЯНС. Этот алгоритм итеративно увеличивал устойчивость между состояниями на узлах так, что при каждой итерации могло быть достигнуто более хорошее состояние, т.е. меньшее энергетическое состояние. Когда алгоритм сходится, мы находим минимум соответствующей функции энергии и получаем действительные значения глубины изображения z. Для сравнения результатов, полученных как здесь, так и в другой литературе, некоторые изображения были использованы из предыдущих публикаций. Они в градациях серого с интенсивностью, лежащей в диапазоне [0; 255] и размерами около 300×300 точек. Первое — это полусферический объект, освещённый со стороны наблюдателя. На рис.2 показано исходное изображение слева, а справа полученная данным алгоритмом карта высот. Второе — на рис. 3 показана голова манекена. Среднее число шагов, требуемых для проведения релаксационного алгоритма, оказалось в диапазоне 3 – 4 итеративных шагов. В этих экспериментах направление источника света было вычислено на основе техники, представленной в [16]. В действительности наш алгоритм очень устойчив к неточностям в значениях направления источника света, что допускает некоторые отклонения в этих значениях без воспроизведения существенных отклонений на вычисленных значениях высот. Эту особенность можно оценить на показанном на рис.4 эксперименте. Как можно отметить, алгоритм достигает достаточно хороших результатов. На поверку результаты очень близки к результатам, полученным в [15]. Тем не менее, наш алгоритм высоко параллелен и очень выгоден для аппаратной реализации. Из-за возможности распознавать в реальном времени форму по затенению, эти характеристики являются наиболее важным вкладом в работу, когда вычисления выполняются на отвечающих необходимым требованиям высоко параллельных машинах или на аналогичных микросхемах СБИС.

Рис 2. Полусферический объект с матовой поверхностью и его трёхмерная форма (слева распознаваемое изображение, справа — результат).

Рис 3. Голова манекена и его трёхмерная форма (слева распознаваемое изображение, справа — результат).

(a) Карта высот при P = Q = 1,0; (б) при P = 1,0; Q = 0,0; (в) при P = 0,0; Q = 1,0. 5. ЗаключениеВ статье рассмотрены некоторые аспекты общей природы различных задач в раннем зрении (т.е. начальных процессах зрения) в связи с оптимизационным подходом и нахождением минимумов функции энергии (функции Ляпунова) в представленной модели. Была описана архитектура ЯНС и найден наиболее подходящий для реализации оптимизационный процесс, основанный на его внутренних свойствах эволюции до глобального состояния минимума энергии. Была описана задача распознавания формы по затенению в терминах привлечённых переменных и возможных подходов к её решению. Была выведена функция энергии, чьё значение минимума соответствует решению задачи распознавания формы по затенению, основанной на концепции пространственного соседства и Случайных полей Маркова. Также показано, что архитектура ЯНС очень выгодна для выполнения таких регуляризационных техник благодаря локальной природе связей между нейронами. В итоге приведены некоторые экспериментальные результаты предложенного алгоритма. Их можно сравнить с остальными, найденными в литературе. Можно увидеть, что результаты, полученные здесь подобны полученным ранее, но этот новый подход ориентирован на параллелизм и аналог реализации на СБИС, допуская в реальном времени решение распознавания формы по отражательной способности (при соответствующем обеспечении). БлагодарностиИзложенные в этой статье исследования поддерживаются FINEP с помощью Аrtificial Intelligence Net в проекте RECOPE и FAPESP. ЛИТЕРАТУРА1. Chua L.O., Yang L., "Cellular Neural Networks: Theory and Applications",

IEEE Trans. on Circuits and Systems, (CAS), Vol.35 (1988), 1257-1290 2. Chua L.O., Roska T., "The CNN Paradigm". IEEE Transactions on Circuits

and Systems (Part I), CAS-40, 3 (1993), 147-156 3. Roska T., Vandewalle J., Cellular Neural Networks. (John Wiley&Sons),

(1993) 4. Poggio T., Torre V., Koch C., „Computational Vision and Regularization

Theory“, Nature, Vol. 317 (1985), 314-319 5. Koch C., Marroquin J., Yuille A., „Analog Neural Networks in Early Vision“,

Proc. Natl. Acad. Sci. USA, Vol. 83 (1986), 4263-4267 6. Wechsler H., Computer Vision, Academic Press, Inc, (1990) 7. Pajares G., Cruz J., Aranda J., „Relaxation by Hopfield Network in Stereo

Image Matching“, Patter Recognition, Vol. 31, No 5 (1998), 561-574 8. Radvanti A., “Structural Analysis of Stereograms for CNN Depth Detection“, IEEE

Trans. Circuits Syst. I, Vol. 46 (1999), 239-252 9. Lithon F., Dragomirescu D., “A Cellular Analog Network for MRF-Based

Motion Detection“, IEEE Trans. Circuits Syst. I, Vol 46 (1999), 281-293 10. Liu D., Michel A., „Sparsely Interconnected Neural Networks for Associative

Memories with Applications to Cellular Neural Networks“. IEEE Transactions on

Circuits and Systems Part II Analog and Digital Signal Processing, Vol. 41, No. 4

(1994), 295-307 11. Horn B.K.P., „Obtaining Shape from Shading Information“. In The Psychology of

Computer Vision, Winston, P.H., (Ed.). New York, McGraw-Hill, (1975), 115-155 12. Yu S.S., Tsai W.H., „Relaxation by the Hopfield Neural Network“, Pattern

Recognition , No. 25(2), (1992), 197-209. 13. Horn B.K.P. „Local Shading Analysis“, IEEE Trans. Pattern Anal. Machine

Intelligence, Vol. PAMI-16, No. 2 (Mar 1984), 170-184 14. Pentland A.P., „Linear Shape from Shading“, Int. J. Comput. Vision, Vol. 4

(1990), 153-162 15. Tsai P.-S., Shah M., „Shape from Shading using Linear Approximation“,

Research Report, University of Central Florida, (1995) 16. Zheng Q., Chellapa R., „Estimation of Illuminant Direction, Albedo, and

Shape from Shading“, IEEE Trans. Pattern Anal. Machine Intelligence, Vol. 13,

No. 7 (Jul 1991), 680-702 17. Grimson W.E.L., From Images to Surfaces: A Computational Study of the Human

Early Visual System, MIT Press, Cambridge, MA, (1981) 18. Lehky, Sejnowski, „Network Model of Shape from Shading: Neural Function

Arises from both Receptive and Projective Fields“, Nature, Vol. 333 (Jun 1988),

452-454 19. Wei G., Hirzinger G., „Learning Shape from Shading by a Multilayer

Network“, IEEE Trans. On Neural Networks, Vol. 7, No. 4 (Jul 1996), 985-995 20. Hopfield J., Tank D., „Neural Computation of Decisions in Optimization

Problems“, Biological Cybernetics, Vol.52 (1985), 141-152 21. Bose N.K., Liang P., Neural Network Fundamentals with Graphs, Algorithms

and Applications, McGraw-Hill Series in Electrical and Computer Engineering,

(1996) 22. Geman S., Geman D., „Stochastic Relaxation, Gibbs Distributions, and the

Bayesian Restoration of Images“, IEEE Trans. Patter Anal. Machine Intelligence,

Vol. PAMI-6, No. 6 (Nov 1984), 721-741 23. Besag J., „On the Statistical Analysis of Dirty Pictures“, J. R. Statist. Soc. B, Vol.

48, No. 3 (1986), 259-302 СОКРАЩЕНИЯ И АББРЕВИАТУРЫИУМ — итеративные условные модели [23] (ICM), алгоритм ПЕРЕМЕННЫЕ И ОБОЗНАЧЕНИЯ В СТАТЬЕ

|

|||||||||||||||||||||||||||||